Tada Pictures | shutterstock.com

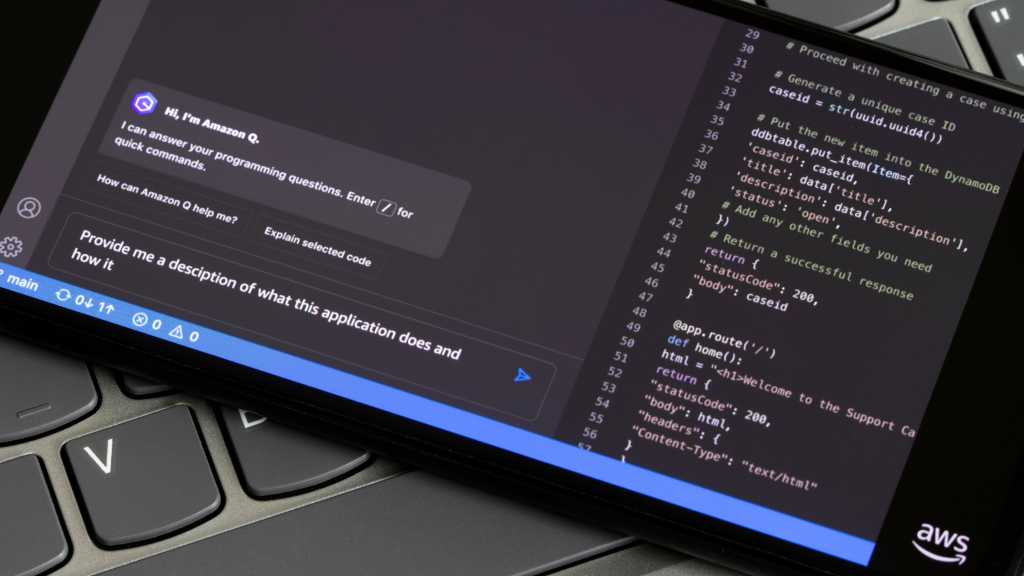

Einem Hacker ist es gelungen, zerstörerische Systembefehle in die Visible-Studio-Code-Extension einzuschleusen, die für den Zugriff auf Amazons KI-gestützten Programmierassistenten Q verwendet wird. Der Angreifer konnte das Entwickler-Device (mit mehr als 950.000 Installationen) über ein nicht-verifiziertes GitHub-Konto verseuchen: Er reichte Ende Juni 2025 einen Pull-Request ein und erlangte daraufhin nach eigener Aussage Administratorrechte, wie 404 Media preliminary berichtete (Paywall).

Der eingeschleuste Code wies das Amazon-Device demnach an, sich wie ein System Cleaner mit Zugriff auf Dateisystem und Cloud Instruments zu verhalten, um Nutzerdaten und Cloud-Ressourcen zu löschen. Das Replace wurde von Amazon über den offiziellen Weg an die Nutzer verteilt – zunächst ohne zu bemerken, dass dieses manipuliert worden struggle. Der Hacker hinter dem Angriff erklärte gegenüber 404 Media, dass er noch weitaus schädlichere Payloads hätte einschleusen können. Er habe sich jedoch stattdessen für diese „milde Variante“ entschieden, um ein Zeichen des Protests gegen Amazons “AI-Safety-Theater” zu setzen.

“Nix passiert, weitermachen”?

“Wir haben einen Versuch, eine bekannte Schwachstelle in zwei Open-Supply-Repositories auszunutzen, um den Code in der Amazon-Q-Developer-Extension für VS Code zu manipulieren, schnell abgewehrt und können bestätigen, dass keine Kundenressourcen betroffen sind”, erklärte ein Sprecher von AWS. Die Probleme in beiden betroffenen Codebasen seien vollständig behoben – keine weiteren Maßnahmen seitens der Kunden erforderlich.

Nichtsdestotrotz unterstreicht der Vorfall die wachsenden Bedenken hinsichtlich der Sicherheit von Generative-AI-Instruments und ihrer Integration in Entwicklungsumgebungen, wie Cybersecurity-Experte Sunil Varkey erklärt: “Dieser Vorfall verdeutlicht, dass leistungsstarke KI-Instruments zunehmend durch böswillige Akteure ausgenutzt werden können, weil robuste Schutzvorkehrungen, durchgängiges Monitoring und wirksame Governance-Leitplanken fehlen”. Wenn KI-Systeme wie Code-Assistenten kompromittiert würden, so Varkey, schaffe das in zweifacher Hinsicht Risiken: Angreifer könnten bösartigen Code in Softwarelieferketten einschleusen, während die Benutzer unwissentlich Schwachstellen oder Hintertüren einführten.

“Der Vorfall zeigt auch, wie sich die Risiken in der Lieferkette bei der KI-Entwicklung verschärfen, wenn Unternehmen sich ohne strenge Überprüfungen auf Open-Supply-Beiträge verlassen”, ergänzt Sakshi Grover, Senior Analysis Supervisor bei IDC Asia Pacific Cybersecurity Companies. Umso wichtiger sei es für die Groups in Unternehmen, KI-spezifische Bedrohungsmodelle in ihre DevSecOps-Praktiken zu integrieren, meint Grover – nur so ließe sich Risiken wie Mannequin Drift, Immediate Injection und semantischen Manipulationen begegnen. Sie empfiehlt: “Unternehmen sollten unveränderliche Launch-Pipelines mit Hash-basierter Verifizierung einführen und Mechanismen in CI/CD-Workflows integrieren, um Anomalien und Manipulationen frühzeitig zu erkennen.”

Schließlich demonstriert der Incident auch, dass selbst die DevSecOps-Reife der großen Cloud-Anbieter in Sachen KI-Entwicklungswerkzeuge ausbaufähig ist. (fm)

Sie wollen weitere interessante Beiträge rund um das Thema IT-Sicherheit lesen? Unser kostenloser Publication liefert Ihnen alles, was Sicherheitsentscheider und -experten wissen sollten, direkt in Ihre Inbox.